Motivation

地面机器人载荷大,续航能力强,可以携带各种传感器对环境进行感知,如激光等负荷较大的传感器以及算力较强的计算设备。但地面移动机器人运动受限,且视野受到障碍物的遮挡,对环境的感知具有局限性。 空中机器人载荷小,续航能力弱,常携带相机等轻量设备进行感知。但其在空间中可以较为灵活的运动,感知范围较大,在多机器人系统中常用于大范围探索的任务。 如何利用空中机器人的大范围感知能力,为地面机器人移动提供先验知识是异构多机器人系统中较为重要的问题。

空中机器人与地面移动机器人的信息匹配具有几个难点:

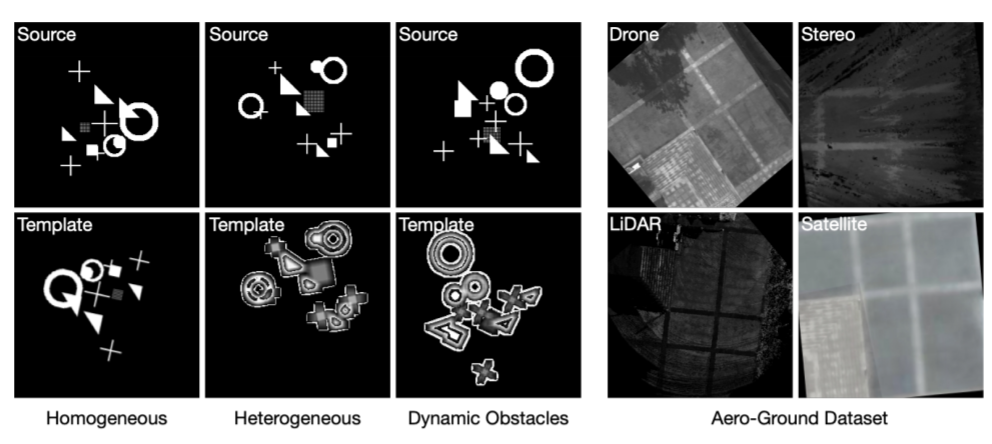

- 空中机器人与地面移动机器人的感知视角差异较大。(Elevation Map -> 俯视图像)

- 空中与地面机器人携带异构的传感器,异构传感器匹配困难。(该方法 - DPCN)

Our Work

论文:Deep Phase Correlation for End-to-End Heterogeneous Sensor Measurements Matching

对于问题一:空地机器人感知视角差异大 空地机器人携带的相机视角差异大,一般图像匹配方法基本失效。

目前研究方向有:

- 针对大视角差场景下的特征点提取与匹配

- 利用一些先验信息对视角进行转换,在统一的视角下进行匹配

本文工作遵循第二个方向,利用局部建图将大视角差的问题统一到俯视图进行匹配。 在之前Elevation Map的工作中,我们利用激光构建了局部稠密地图,在本文中我们将图像与点云融合,以2.5d地图表示。实际上2.5d地图是以2d栅格地图的形式存储,因此可以很容易地将其转换到图像格式。 在RCAR的空地协同方法中,我们展示了地面局部稠密地图到图像的转换,但其图像质量较差,与空中下视图像具有较大差别,因此在RCAR的文章中,我们试图用传统的方法进行匹配。

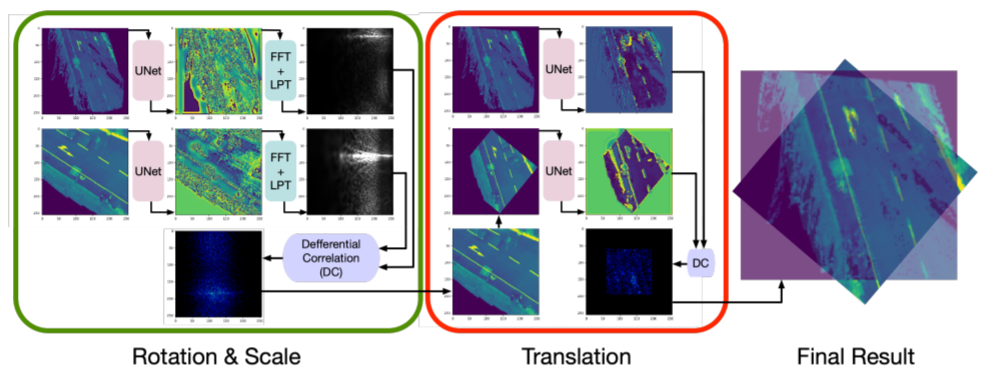

在本文中,我们试图利用深度学习的方式重新处理该问题。 本文采用传统图像匹配方法中的傅里叶变换以及相位相关算法,将其改写为可微分的求解器加入到网络中进行数据驱动的学习,以达到异构图像的x y theta三自由度的配准。

本方法的网络架构如下图所示:

Experiments

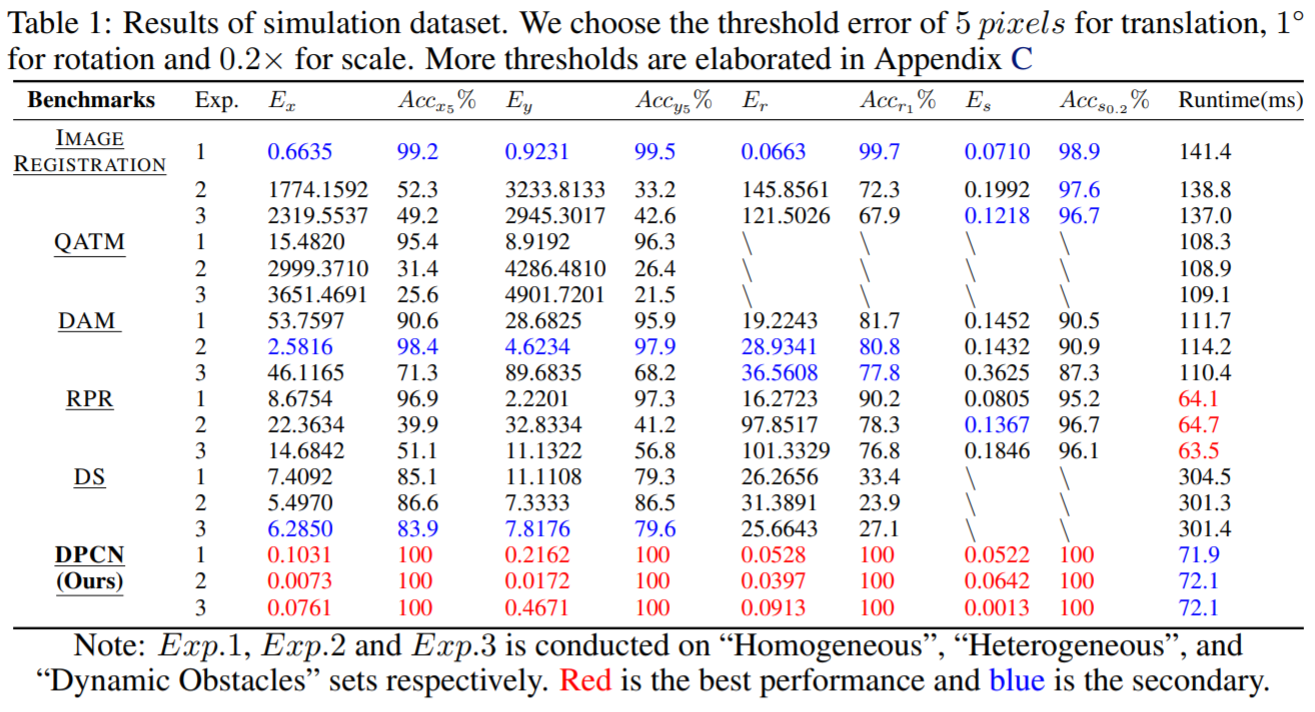

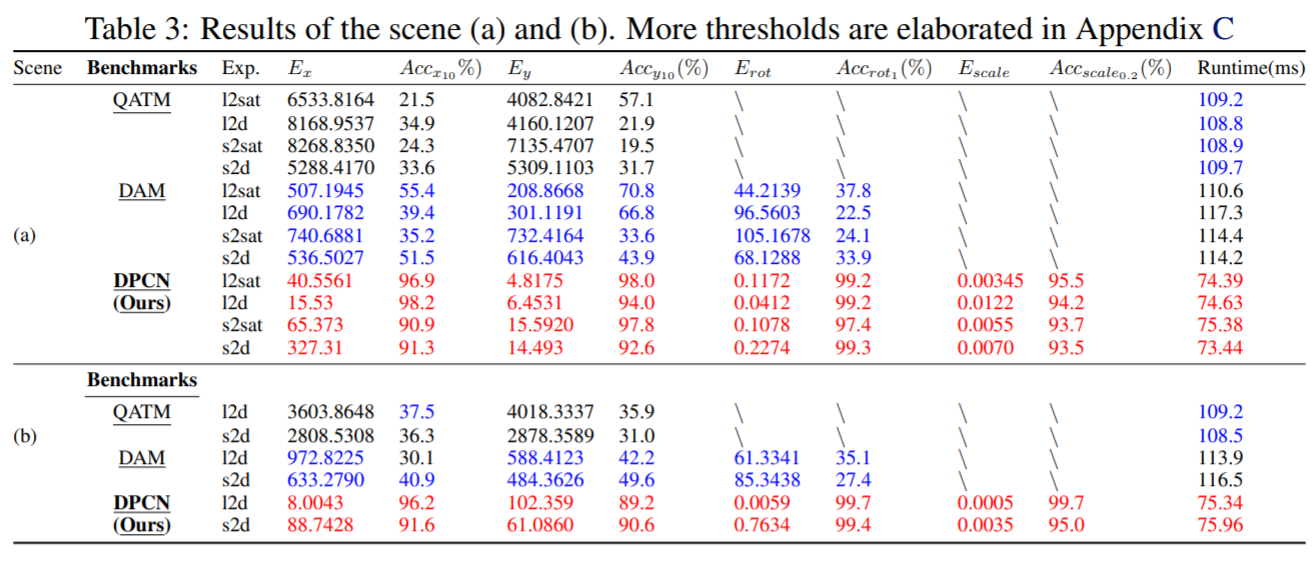

本方法在仿真数据以及真实数据集中的实验结果与其他方法的对比:

仿真数据集实验结果:

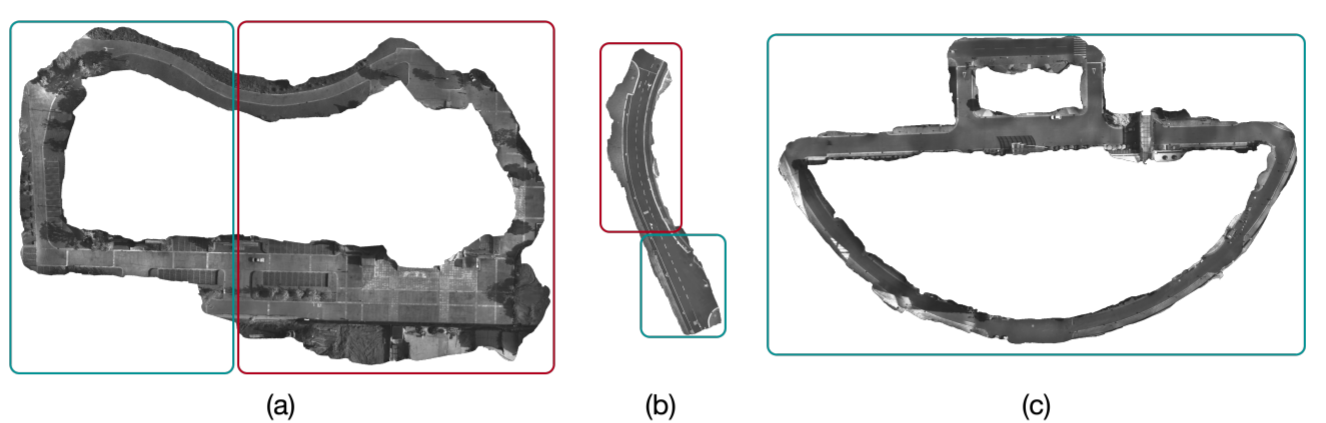

真实数据集:

真实数据集实验结果:

本文工作还提出了空地数据集用于后续研究: